Mit Experimenten die Performance im Omnichannel-Marketing steigern

Um die Wirkungskraft von Tests zu verdeutlichen, ein Beispiel: die Wahlkampfkampagne von Barack Obama griff verstärkt auf A/B-Tests zurück, um in der Wähleransprache verschiedene Banner-Varianten zu testen. Dank umfangreicher Tests erzielte der erfolgreichste Banner eine um 40,6 % höhere Conversion-Rate und verbuchte knapp 2,9 Millionen neue Newsletter-Abonnentinnen und -Abonnenten. Damit sammelte das Wahlkampf-Team beachtliche 60 Mio. US-Dollar an zusätzlichen Spendengeldern ein. Das Endergebnis: Barack Obama wurde 2009 zum US-Präsidenten gewählt.

Testen macht Sinn

Sie sehen: Testen macht mehr als nur Sinn. Auch deshalb, weil Tests sehr kostengünstig sind und keinen zusätzlichen Adspent verursachen. Auf diese Weise lässt sich auch das vorhandene Marketing-Automation-Setup optimieren. Das führt zu einer höheren Kundenloyalität und zu verbesserten KPIs. Je mehr und öfter Sie also testen – und das sollten Sie unbedingt –, desto größer der Lerneffekt bzw. desto effizienter arbeiten Sie. Und das macht sich auch im Endergebnis bezahlt. Sie werden sehen, Umsatz und Leads werden wachsen.

Zum Start: Experimentation mit der Betreffzeile zeigt Wirkung

Aber wie findet sich innerhalb der Marketing-Automation ein geeigneter Testgegenstand? Was genau kann alles getestet werden? Vornweg: Der Katalog ist beinahe endlos. Beispiele sind: die Absenderadresse (Was ist besser: Person oder allgemein?), Content / Message, Betreffzeile, Wochentag, Zeit (Sendezeit, Frequenz), Call-to-Action, Kanal, Bilder (mit / ohne, Hoch- / Querformat), Farben (monochrom oder Farbe), Personas / Zielgruppe, Personalisierung usw. usf.

Wichtig ist: Starten Sie am Anfang! Also: Bei der Betreffzeile

Auch Optimizely-Kunden experimentieren mit Abstand am meisten mit der Betreffzeile. 72 % der Kunden unterzogen dieses Element einem A/B-Test. Aus gutem Grund, denn Studien zeigen, dass etwa die persönliche Ansprache in der Betreffzeile die Öffnungsrate im Vergleich zu nicht personalisierten Betreffzeilen um 22 % erhöht. So erreichen zum Beispiel die E-Mail-Opens in der Touristik dank personalisierter Betreffzeilen Spitzenwerte von 47 %.

Hier ein kleines Zahlenbeispiel: Sie verzeichnen eine Conversion Rate von 5% und einen durchschnittlichen Warenkorbwert von 80 EUR. Bei einer durchschnittlichen Öffnungsrate von 30 % pro 1.000 Empfänger werden ca. 260 EUR mehr Umsatz realisiert. Es lohnt sich also zu experimentieren!

So gelingt der Experimentation-Start

A/B-Tests eigen sich insofern auch hervorragend für den Experimentation-Einstieg. Diese Schritt-für-Schritt-Anleitung unterstützt Sie beim Start. Dafür eignet sich die Betreffzeile ganz besonders. Denn sie wirkt sich unmittelbar auf die Öffnungsrate aus. Beim Betreffzeilen-Test kommt es auf die Definition einer oder mehrerer zu testenden Variablen an. Sie repräsentiert den Testgegenstand, deren Wirkung im Original und in einer Variante geprüft wird. Der Einfachheit halber starten wir mit einer Variablen. Das kann zum Beispiel die Ansprache in der Betreffzeile sein. Sie kann persönlich - mit Nennung des Geschlechts und des Nachnamens (in unserem Beispiel die Variante) – oder neutral (in unserem Beispiel das Original) erfolgen. Die unterschiedlichen Ausprägungen einer Variable sollten dabei im Vorfeld über ein Verständigungsglossar (vgl. dazu den Abschnitt unten „Use Case: Statistisch signifikante A/B-Tests“) präzise definiert werden.

Und das könnten Sie in der Betreffzeile testen:

- Fügen Sie Ihrer Varianten-Betreffzeile eine persönliche Note hinzu

- Verwenden Sie Zahlen anstelle von Text in Ihrer Varianten-Betreffzeile

- Geben Sie Ihrer Varianten-Betreffzeile ein Gefühl der Dringlichkeit

- Testen Sie direkte Texte im Vergleich zu "Teaser"- Texten in Ihrer Betreffzeile

- Testen Sie motivierende Texte ("Handeln Sie jetzt") im Vergleich zu Negation ("Verpassen Sie es nicht") in Ihrer Betreffzeile

- Stellen Sie verschiedene Produkte in Ihrer Varianten-Betreffzeile vor

- Ganz wichtig! Ändern Sie Ihren Pre-Header-Text

Achtung! Folgen Sie immer der gleichen Anleitung beim Experimentieren mit gleichen Variablen!

Test-Setup

Hypothese erstellen

Um einen A/B-Test für die Betreffzeile durchzuführen, muss zunächst ein Testziel definiert werden (Was soll erreicht werden?). Dazu wird eine Hypothese formuliert. Sie könnte in etwa so lauten:

„Eine personalisierte Ansprache z.B. mit Vor- und Nachnamen in der Betreffzeile erreicht eine um 20% bessere Öffnungsrate als eine nicht personalisierte Betreffzeile.“

(TIPP: Nicht zu komplexe Hypothesen verwenden, das erschwert die Nachprüfbarkeit!)

Operatives Unterscheidungskriterium im Hinblick auf die Hypothese ist also das in der Kontrollgruppe zu prüfende personalisierende Element der Varianten-Betreffzeile – üblicherweise die persönliche Ansprache inkl. Namensnennung. Als zentrale Metrik dient hier die Öffnungsrate.

Variable: Betreffzeile

Ein A/B-Test der Variablen „Betreffzeile“ unterteilt die Empfänger-Zielgruppe zunächst in die Gruppen A (die Testgruppe) und B (die Kontrollgruppe). Die Aufteilung erfolgt nach dem Zufallsprinzip. Danach wird das Testobjekt, also die Betreffzeile, in zweifacher Ausführung erstellt: einmal als Original, das auch die Original-Betreffzeile (ohne persönliche Ansprache) enthält, und einmal als Alternative mit einer vom Original abweichenden, also personalisierten Betreffzeile. Anschließend werden die Samples an die jeweiligen Gruppen versendet.

Wichtig!

Beide Varianten sollten sich generell nur in dieser einen Komponente unterscheiden. Der Grund: Akzeptanz-Unterschiede lassen sich dadurch eindeutig auf die veränderte Version zurückführen.

Use Case: Statistisch signifikante A/B-Tests

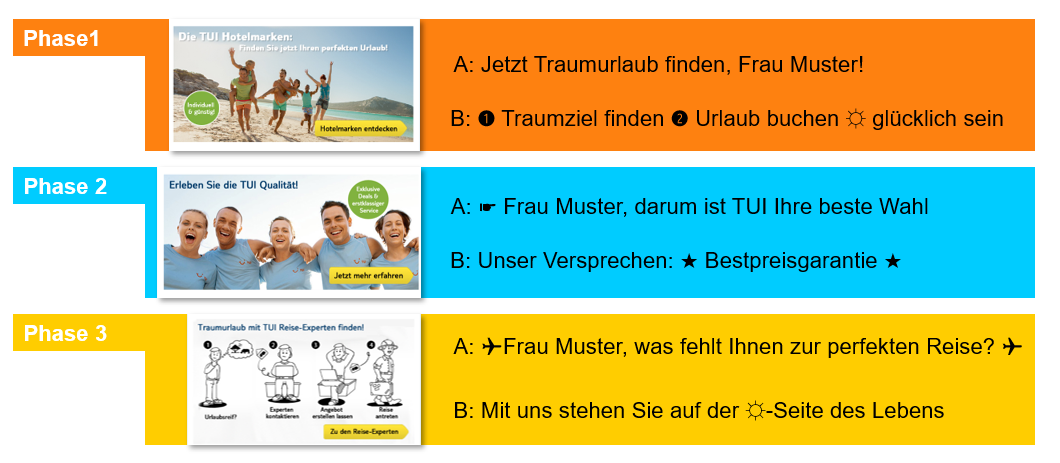

Eine automatisierte E-Mail-Kampagne eines Reiseveranstalters kann beispielsweise so aussehen:

In der Vorbereitung einer Kampagne wird für jede Phase die Betreffzeile A/B-getestet, aus der schließlich drei Gewinner hervorgehen, die im Anschluss in der realen Marketing-Automation zum Einsatz kommen. Bevor dies geschieht, ist es jedoch entscheidend, dass die Ergebnisse des A-/B-Tests korrekt bewertet werden. Dazu muss der A-/B-Test zwei Bedingungen erfüllen:

- Relevante KPIs: Ausschlaggebend ist, ob der A/B-Test auf die entsprechend relevanten KPIs abzielt. Hier schafft ein Verständigungsglossar Klarheit. Es definiert KPIs und macht deren Geltungsbereich für alle Beteiligten transparent. Damit auch ihr Chef genau weiß was in den KPIs enthalten ist.

Als Metrik für die Betreffzeile in unserem Beispiel spielt insbesondere der Key Performance Indicator (KPI) „Unique Open Rate“ (UOR, Öffnungsrate) eine zentrale Rolle. Die UOR gibt Auskunft darüber, wie groß der Anteil jener Personen ist, die den Newsletter nach dem Lesen der Betreffzeilen A und B geöffnet haben. Aber: Um festzustellen, ob der Test tatsächlich ein Erfolg ist, dürfen KPIs wie Click-to-open-Rate (CTOR) und Conversion Rate (CR) nicht aus den Augen gelassen werden. - Statistisch Signifikanz: Damit die Ergebnisse des A/B-Tests sich als statistisch signifikant erweisen, müssen Kontroll- und Testgruppe ein Delta von mindesten 20 % (gemessen an der UOR der Kontrollgruppe) vorweisen. Liegt die UOR der Kontrollgruppe beispielsweise bei 10 % und die UOR des Tests bei 13 % erfüllt der A/B-Test die Anforderungen der statistische Signifikanz, da in diesem Fall eine Veränderung von mindestens 20 % vorliegt.

Diese vier Schritte fassen zusammen, wie Sie das Beste aus einem Experiment herausholen:

- Variable / Test definieren

- Hypothese erstellen

- Testprozess

- Analyse: Testergebnisse bewerten

Fazit

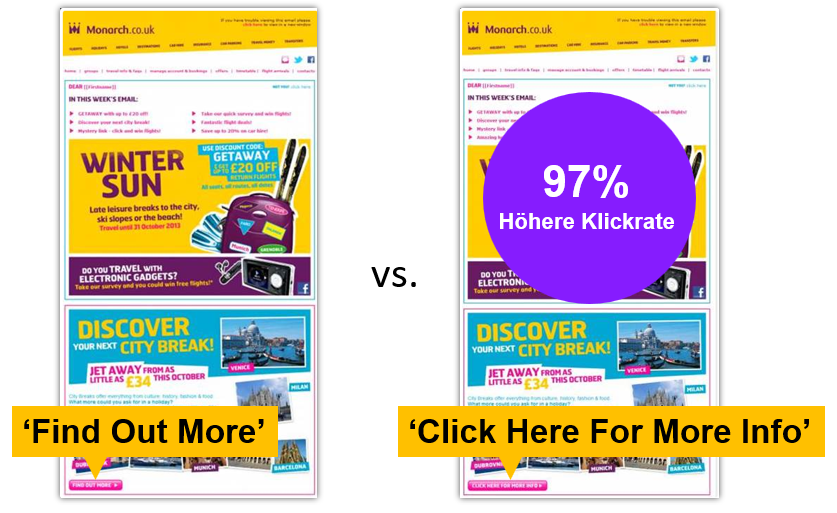

A/B-Tests liefern belastbare Informationen darüber, dass bereits kleine Details wie etwa eine personalisierte Ansprache einen großen Mehrwert erzielen können. Sie eignen sich insofern nicht nur für die E-Mail-Kommunikation. Immer mehr Unternehmen setzten A/B-Test zur kanalübergreifenden Optimierung ein. So lassen sich auch Push-Benachrichtigungen oder Transaktional-Mails per A-/B-Test optimieren. Schon Beschriftung und Farbwahl eines Call-to-Action-Buttons bewirken einen große Effekt in den Klickzahlen. Aber: Die letzte Gewissheit über diese Erkenntnis liefern eben erst A/B-Tests.

- Zuletzt geändert: 29.01.2025 15:37:42