A/B-Tests

Was ist A/B-Testing?

A/B-Testing (auch bekannt als Split-Testing oder Bucket-Testing) ist eine Methode, bei der zwei Versionen einer Webseite oder App miteinander verglichen werden, um festzustellen, welche Variante besser abschneidet. Bei A/B-Tests handelt es sich im Wesentlichen um ein Experiment, bei dem Nutzern zwei oder mehr Varianten einer Seite nach dem Zufallsprinzip angezeigt werden und mit Hilfe statistischer Analysen ermittelt wird, welche Variante für ein bestimmtes Konversionsziel besser geeignet ist.

Wenn Sie einen A/B-Test durchführen, bei dem eine Variante direkt mit einer aktuellen Erfahrung verglichen wird, können Sie gezielte Fragen zu Änderungen an Ihrer Website oder App stellen und anschließend Daten über die Auswirkungen dieser Änderungen sammeln.

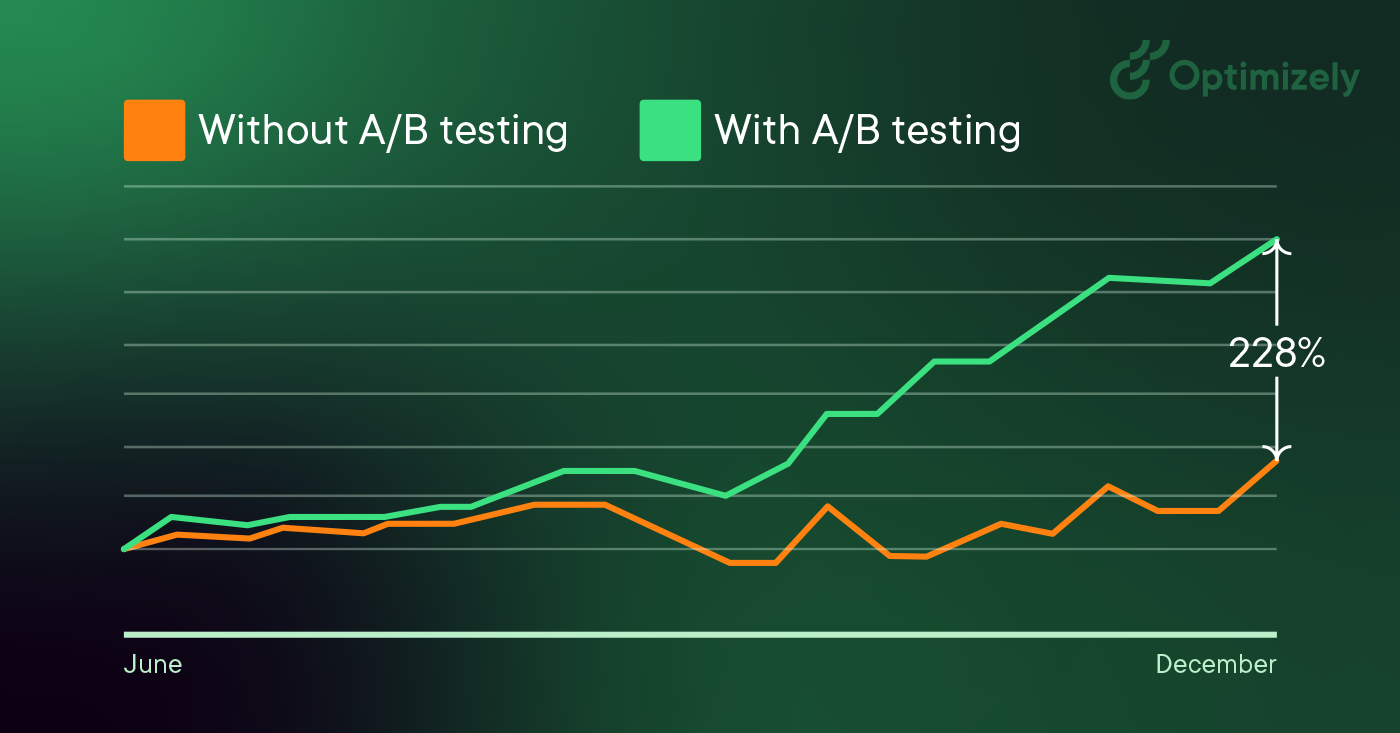

Tests nehmen der Website-Optimierung das Rätselraten und ermöglichen datengestützte Entscheidungen, die die Geschäftsgespräche von "wir denken" auf "wir wissen" umstellen. Indem Sie die Auswirkungen von Änderungen auf Ihre Kennzahlen messen, können Sie sicherstellen, dass jede Änderung zu positiven Ergebnissen führt.

Wie A/B-Tests funktionieren

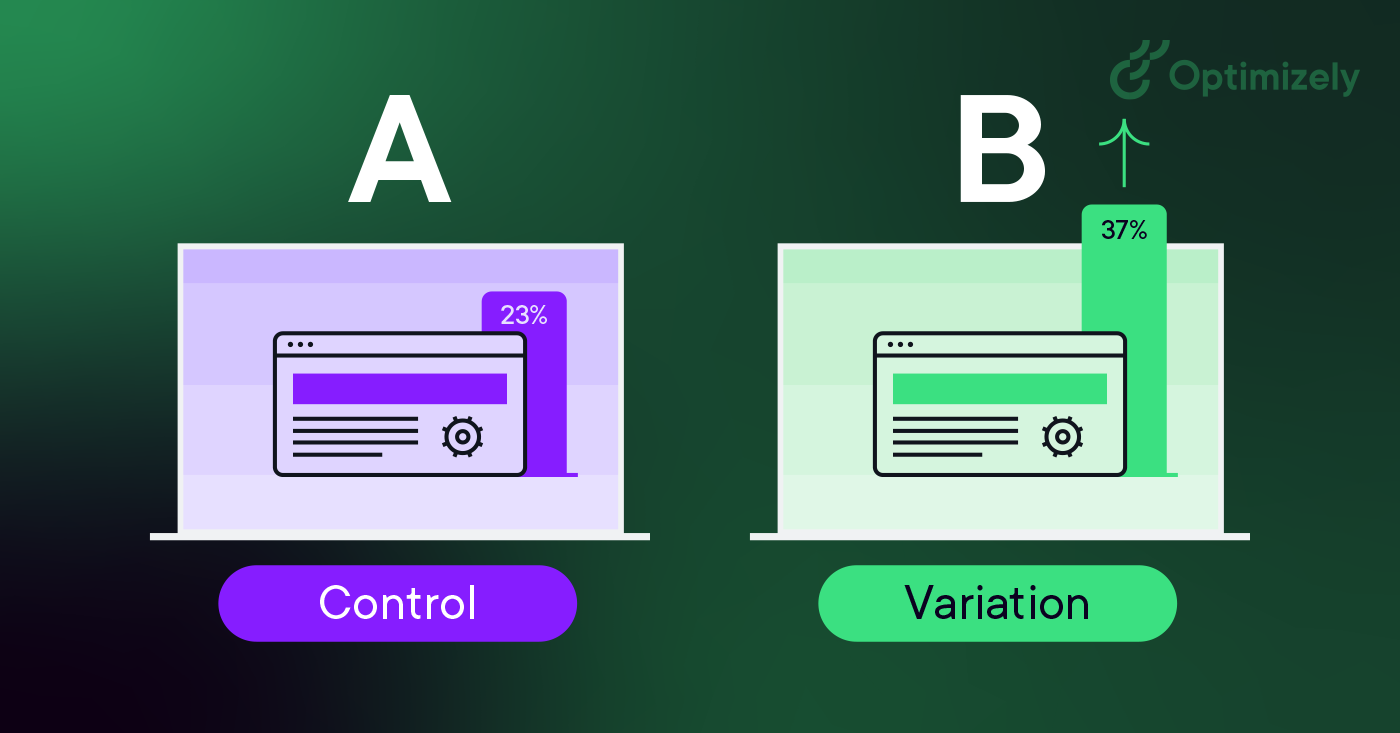

Bei einem A/B-Test nehmen Sie eine Webseite oder einen App-Bildschirm und ändern ihn, um eine zweite Version derselben Seite zu erstellen. Diese Änderung kann so einfach sein wie eine einzelne Überschrift oder Schaltfläche oder eine komplette Umgestaltung der Seite. Dann wird der Hälfte Ihrer Besucher die ursprüngliche Version der Seite (bekannt als Kontrolle oder A) und der anderen Hälfte die veränderte Version der Seite (die Variation oder B) angezeigt.

Während den Besuchern entweder die Kontroll- oder die Variationsversion angezeigt wird, wird ihr Engagement mit jeder Erfahrung gemessen und in einem Dashboard gesammelt und durch eine Statistik-Engine analysiert. Sie können dann feststellen, ob die Änderung der Erfahrung (Variation oder B) einen positiven, negativen oder neutralen Effekt im Vergleich zur Grundlinie (Kontrolle oder A) hatte.

Warum Sie A/B-Tests durchführen sollten

A/B-Tests ermöglichen es Einzelpersonen, Teams und Unternehmen, vorsichtige Änderungen an ihren Benutzererfahrungen vorzunehmen und gleichzeitig Daten über die Auswirkungen zu sammeln. Auf diese Weise können sie Hypothesen aufstellen und herausfinden, welche Elemente und Optimierungen ihrer Erlebnisse das Nutzerverhalten am stärksten beeinflussen. Auf der anderen Seite können sie auch eines Besseren belehrt werden - ihre Meinung über das beste Erlebnis für ein bestimmtes Ziel kann durch einen A/B-Test widerlegt werden.

A/B-Tests dienen nicht nur der Beantwortung einer einmaligen Frage oder der Beilegung einer Meinungsverschiedenheit, sondern können auch dazu verwendet werden, ein bestimmtes Erlebnis oder ein einzelnes Ziel wie die Optimierung der Konversionsrate (CRO) im Laufe der Zeit kontinuierlich zu verbessern.

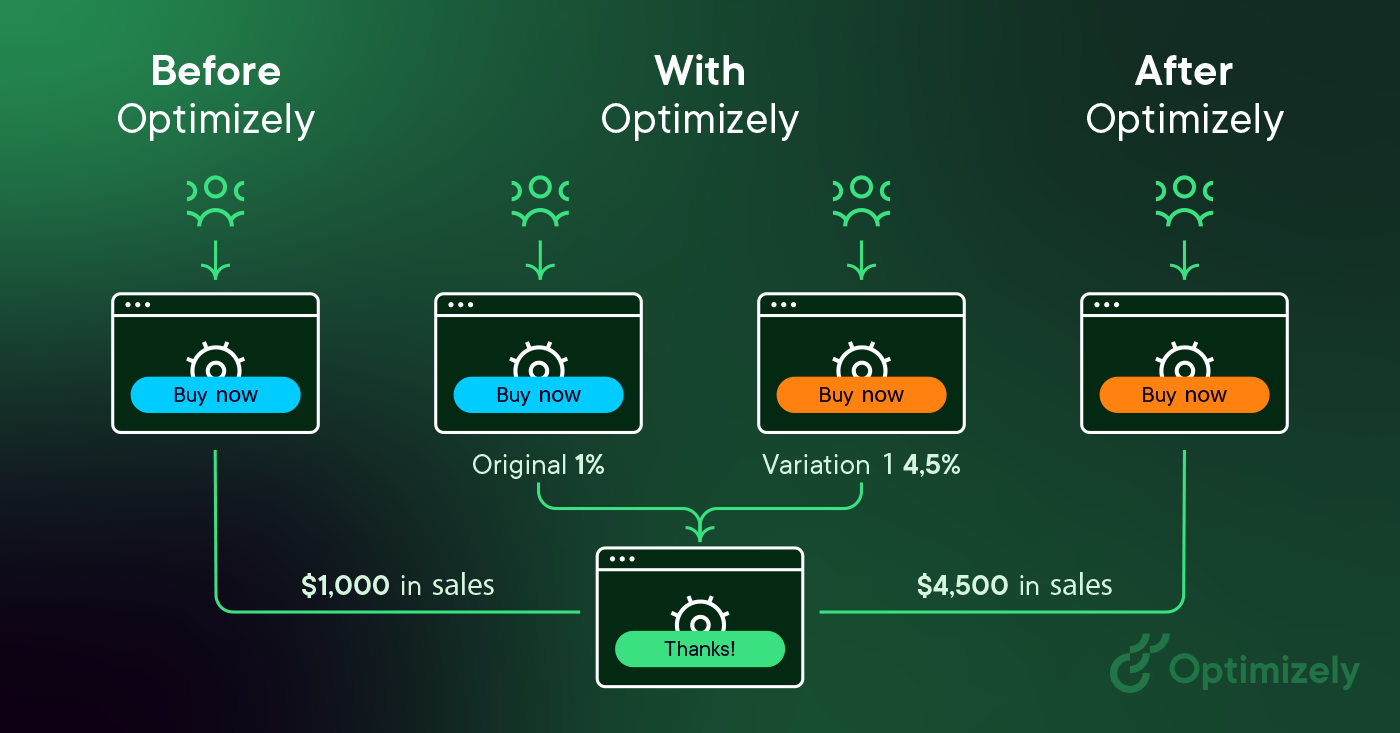

Ein B2B-Technologieunternehmen möchte vielleicht die Qualität und das Volumen seiner Vertriebsleads über Kampagnen-Landingpages verbessern. Um dieses Ziel zu erreichen, würde das Team A/B-Tests mit Änderungen an der Überschrift, der Betreffzeile, den Formularfeldern, dem Call-to-Action und dem Gesamtlayout der Seite durchführen, um die Absprungrate zu senken, die Zahl der Konversionen und Leads zu erhöhen und die Klickrate zu verbessern.

Durch das Testen einzelner Änderungen können sie feststellen, welche Änderungen sich auf das Besucherverhalten auswirken und welche nicht. Im Laufe der Zeit können die Auswirkungen mehrerer erfolgreicher Änderungen aus Experimenten kombiniert werden, um die messbare Verbesserung einer neuen Erfahrung gegenüber der alten zu demonstrieren.

Diese Methode zur Einführung von Änderungen an einem Benutzererlebnis ermöglicht es auch, das Erlebnis für ein gewünschtes Ergebnis zu optimieren und kann entscheidende Schritte in einer Marketingkampagne effektiver machen.

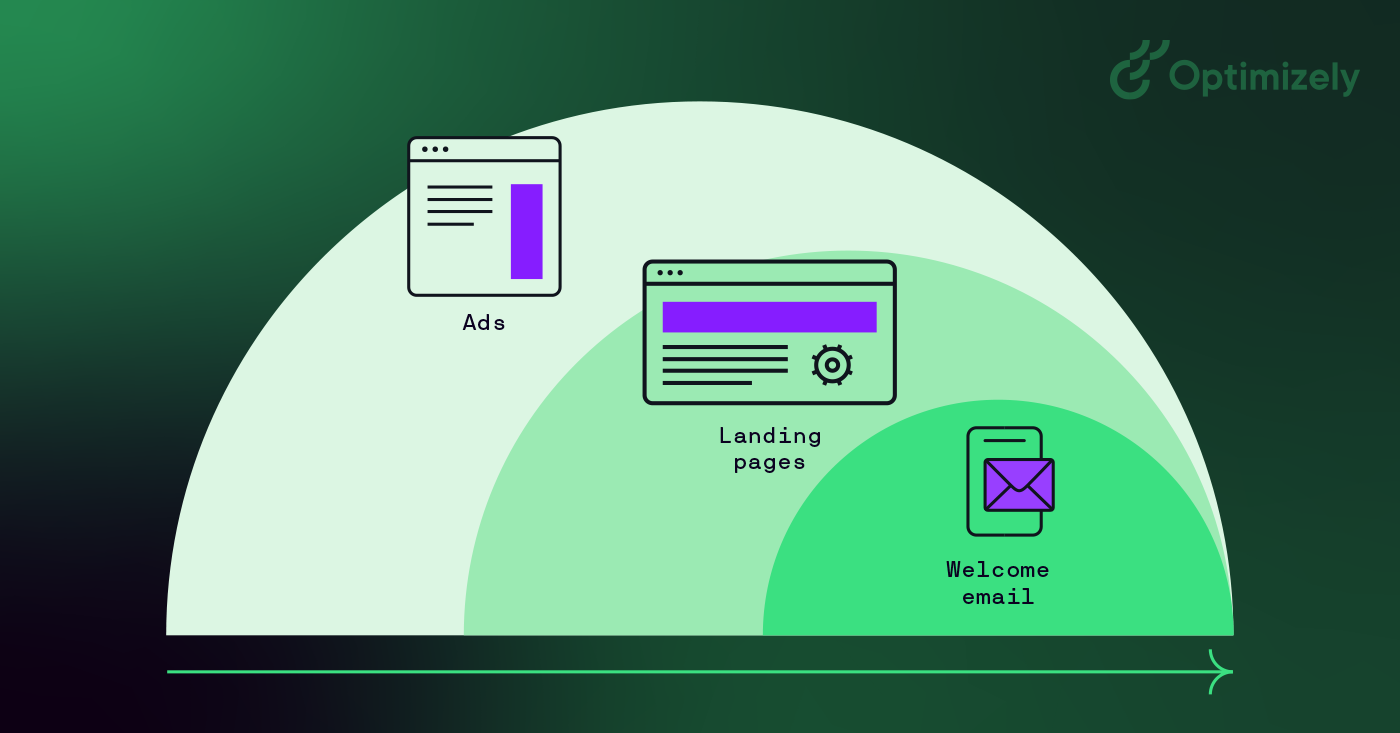

Durch das Testen von Anzeigentexten können Marketingexperten herausfinden, welche Versionen mehr Klicks anziehen. Durch das Testen der anschließenden Landing Page können sie herausfinden, welches Layout Besucher am besten in Kunden verwandelt. Die Gesamtausgaben für eine Marketingkampagne können sogar gesenkt werden, wenn die Elemente der einzelnen Schritte so effizient wie möglich arbeiten, um neue Kunden zu gewinnen.

A/B-Tests und Produktexperimente können auch von Produktentwicklern und -designern genutzt werden, um die Auswirkungen neuer Funktionen oder Änderungen am Benutzererlebnis zu demonstrieren. Produkt-Onboarding, Benutzerbindung, Modals und produktinterne Erlebnisse können alle mit A/B-Tests optimiert werden, sofern die Ziele klar definiert sind und Sie eine eindeutige Hypothese haben.

A/B-Testing-Prozess

Im Folgenden finden Sie einen Rahmen für A/B-Tests, den Sie für die Durchführung von Tests verwenden können:

-

Sammeln Sie Daten: Ihr Analysetool (z. B. Google Analytics) gibt oft Aufschluss darüber, wo Sie mit der Optimierung beginnen können. Es ist hilfreich, mit stark frequentierten Bereichen Ihrer Website oder App zu beginnen, damit Sie schneller Daten sammeln können. Achten Sie bei der Optimierung der Konversionsrate darauf, dass Sie Seiten mit hohen Absprung- oder Abbruchraten finden, die verbessert werden können. Ziehen Sie auch andere Quellen wie Heatmaps, soziale Medien und Umfragen heran, um neue Bereiche für Verbesserungen zu finden.

-

Bestimmen Sie Ziele: Ihre Konversionsziele sind die Metriken, anhand derer Sie feststellen, ob die Variation erfolgreicher ist als die ursprüngliche Version oder nicht. Ziele können alles sein, vom Klicken auf eine Schaltfläche oder einen Link bis hin zum Kauf eines Produkts.

-

Erstellen Sie eine Testhypothese: Sobald Sie ein Ziel festgelegt haben, können Sie Ideen für A/B-Tests entwickeln und Testhypothesen aufstellen, warum Sie glauben, dass sie besser sind als die aktuelle Version. Sobald Sie eine Liste von Ideen haben, priorisieren Sie diese nach der erwarteten Wirkung und der Schwierigkeit der Umsetzung.

-

Erstellen Sie verschiedene Varianten: Verwenden Sie Ihre A/B-Testing-Software (z. B. Optimizely Experiment) und nehmen Sie die gewünschten Änderungen an einem Element Ihrer Website oder mobilen App vor. Dabei kann es sich um die Änderung der Farbe einer Schaltfläche, die Änderung der Reihenfolge von Elementen in der Seitenvorlage, das Ausblenden von Navigationselementen oder etwas völlig anderes handeln. Viele führende A/B-Testing-Tools verfügen über einen visuellen Editor, mit dem sich diese Änderungen leicht vornehmen lassen. Führen Sie Ihr Experiment durch, um sicherzustellen, dass die verschiedenen Versionen den Erwartungen entsprechen.

-

Experiment starten: Starten Sie Ihr Experiment und warten Sie darauf, dass die Besucher daran teilnehmen! Zu diesem Zeitpunkt werden die Besucher Ihrer Website oder App nach dem Zufallsprinzip entweder der Kontrollversion oder der Variante Ihres Erlebnisses zugewiesen. Ihre Interaktion mit jedem Erlebnis wird gemessen, gezählt und mit der Grundlinie verglichen, um festzustellen, wie beide Varianten abschneiden.

-

Warten Sie auf die Testergebnisse: Je nachdem, wie groß Ihre Stichprobe (das Zielpublikum) ist, kann es eine Weile dauern, bis Sie ein zufriedenstellendes Ergebnis erhalten. Gute Versuchsergebnisse zeigen Ihnen, wann die Ergebnisse statistisch signifikant und vertrauenswürdig sind. Andernfalls wäre es schwer zu sagen, ob Ihre Änderung wirklich etwas bewirkt hat.

- Analysieren Sie die Ergebnisse: Nach Abschluss Ihres Experiments ist es an der Zeit, die Ergebnisse zu analysieren. Ihre A/B-Testing-Software stellt die Daten aus dem Experiment dar und zeigt Ihnen den Unterschied zwischen den beiden Versionen Ihrer Seite und ob es einen statistisch signifikanten Unterschied gibt. Es ist wichtig, statistisch signifikante Ergebnisse zu erzielen, damit Sie sich auf das Ergebnis des Tests verlassen können.

Wenn Ihre Variante ein Gewinner ist, herzlichen Glückwunsch 🎉! Prüfen Sie, ob Sie die Erkenntnisse aus dem Experiment auf andere Seiten Ihrer Website übertragen können, und arbeiten Sie weiter am Experiment, um Ihre Ergebnisse zu verbessern. Wenn Ihr Experiment ein negatives Ergebnis oder gar kein Ergebnis liefert, machen Sie sich keine Sorgen. Nutzen Sie das Experiment als Lernerfahrung und entwickeln Sie neue Hypothesen, die Sie testen können.

Unabhängig vom Ergebnis Ihres Experiments sollten Sie Ihre Erfahrungen für künftige Tests nutzen und kontinuierlich an der Optimierung Ihrer App oder Website arbeiten.

A/B-Test-Ergebnisse

Je nach Art der Website oder App, die Sie testen, werden die Ziele unterschiedlich sein. Auf einer Einzelhandelswebsite würden Sie beispielsweise mehr Tests durchführen, um Käufe zu optimieren, während Sie auf einer B2B-Website mehr Experimente durchführen könnten, um Leads zu optimieren.

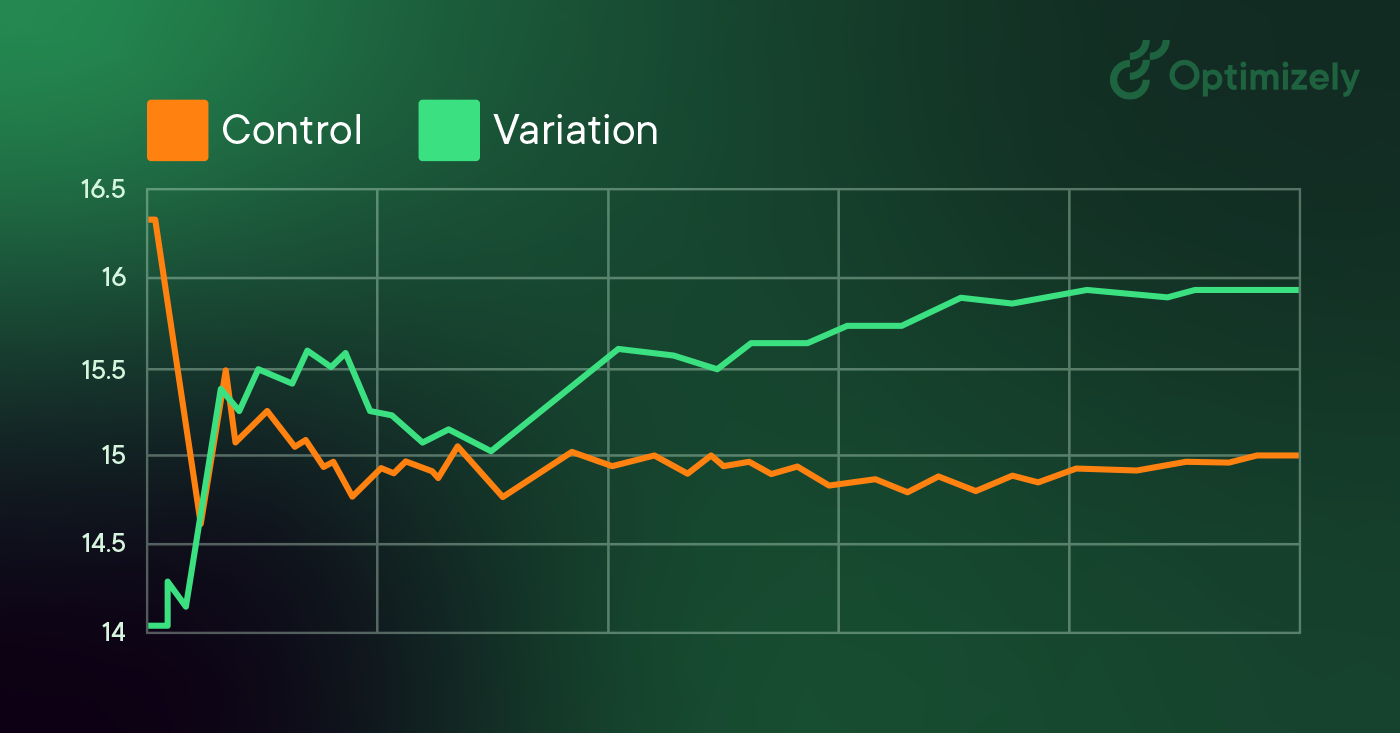

Das bedeutet auch, dass Ihre Ergebnisse je nach Art der Website oder App anders aussehen werden. In der Regel werden die Ziele vor Beginn des A/B-Tests festgelegt und am Ende ausgewertet. Einige A/B-Test-Tools ermöglichen es Ihnen, die Ergebnisse in Echtzeit zu sehen, während sie eingehen, oder die Ziele Ihrer Tests nach Abschluss des Experiments zu ändern.

Ein Dashboard mit den Testergebnissen zeigt 2 (oder mehr) Varianten, ihr jeweiliges Publikum und die erreichten Ziele an. Angenommen, Sie optimieren für Klicks auf einen Call-to-Action (CTA) auf einer Website. Eine typische Ansicht würde Besucher und Klicks sowie eine Konversionsrate enthalten - den Prozentsatz der Besucher, die zu einer Konversion führten.

Segmentierung von A/B-Tests

Größere Websites und Anwendungen verwenden für ihre A/B-Tests häufig eine Segmentierung. Wenn Ihre Besucherzahl hoch genug ist, ist dies eine wertvolle Methode, um Änderungen für bestimmte Besuchergruppen zu testen. Ein gängiges Segment für A/B-Tests ist die Aufteilung in neue Besucher und wiederkehrende Besucher. So können Sie Änderungen an Elementen testen, die nur für neue Besucher gelten, z. B. Anmeldeformulare.

Ein häufiger Fehler bei A/B-Tests besteht jedoch darin, zu kleine Zielgruppen für Tests zu erstellen. Daher kann es sehr lange dauern, bis statistisch signifikante Ergebnisse erzielt werden und festgestellt werden kann, welche Auswirkungen Ihre Änderung auf einen bestimmten Website-Besucher hatte. Daher ist es wichtig, vor Beginn eines Experiments zu prüfen, wie groß Ihre Segmente sind, um falsch positive Ergebnisse zu vermeiden.

A/B-Tests und SEO

Google erlaubt und fördert A/B-Tests und hat erklärt, dass die Durchführung von A/B- oder multivariaten Tests kein inhärentes Risiko für den Suchrang Ihrer Website darstellt. Es ist jedoch möglich, Ihren Suchrang zu gefährden, wenn Sie ein A/B-Test-Tool für Zwecke wie Cloaking missbrauchen. Google hat einige Best Practices formuliert, um sicherzustellen, dass dies nicht passiert:

-

Kein Cloaking: Beim Cloaking werden Suchmaschinen andere Inhalte angezeigt, als sie ein normaler Besucher sehen würde. Cloaking kann dazu führen, dass Ihre Website herabgestuft oder sogar aus den Suchergebnissen entfernt wird. Um Cloaking zu verhindern, sollten Sie die Besuchersegmentierung nicht missbrauchen, um dem Googlebot je nach User-Agent oder IP-Adresse unterschiedliche Inhalte anzuzeigen.

-

Verwenden Sie rel="canonical": Wenn Sie einen Split-Test mit mehreren URLs durchführen, sollten Sie das Attribut rel="canonical" verwenden, um die Variationen auf die ursprüngliche Version der Seite zurück zu führen. Dadurch wird verhindert, dass Googlebot durch mehrere Versionen derselben Seite verwirrt wird.

-

Verwenden Sie 302-Weiterleitungen anstelle von 301-Weiterleitungen: Wenn Sie einen Test durchführen, bei dem die Original-URL auf eine Variations-URL umgeleitet wird, verwenden Sie eine 302er (temporäre) Umleitung im Gegensatz zu einer 301er (permanenten) Umleitung. Dadurch wird Suchmaschinen wie Google mitgeteilt, dass die Weiterleitung vorübergehend ist und dass die ursprüngliche URL indiziert bleiben sollte und nicht die Test-URL.

Ein Medienunternehmen möchte vielleicht seine Leserschaft vergrößern, die Verweildauer der Leser auf seiner Website erhöhen und seine Artikel durch die Weitergabe in sozialen Netzwerken verstärken. Um diese Ziele zu erreichen, könnten sie Variationen testen:

- E-Mail-Anmeldemodale

- Empfohlene Inhalte

- Schaltflächen zum sozialen Austausch

Ein Reiseunternehmen möchte vielleicht die Anzahl der erfolgreichen Buchungen über seine Website oder mobile App erhöhen oder die Einnahmen aus Zusatzkäufen steigern. Um diese Metriken zu verbessern, können sie Variationen testen von:

- Homepage-Suchmodale

- Seite mit den Suchergebnissen

- Präsentation zusätzlicher Produkte

Ein E-Commerce-Unternehmen möchte vielleicht das Kundenerlebnis verbessern, um die Anzahl der abgeschlossenen Kaufvorgänge und den durchschnittlichen Bestellwert zu erhöhen oder den Umsatz im Weihnachtsgeschäft zu steigern. Um dies zu erreichen, können sie A/B-Tests durchführen:

- Homepage-Werbeaktionen

- Elemente der Navigation

- Komponenten des Checkout-Trichters

Ein Technologieunternehmen möchte vielleicht die Zahl der hochwertigen Leads für sein Vertriebsteam erhöhen, die Zahl der Nutzer von kostenlosen Testversionen steigern oder einen bestimmten Käufertyp ansprechen. Sie könnten testen:

- Lead-Formularfelder

- Ablauf der Anmeldung für die kostenlose Testversion

- Homepage-Botschaften und Call-to-Action

A/B-Testing-Beispiele

Diese A/B-Testing-Fallstudien zeigen, welche Art von Ergebnissen die innovativsten Unternehmen der Welt durch A/B-Testing mit Optimizelys Lösung Experiment erzielt haben